Racismo artificial: cuando los algoritmos discriminan

La Inteligencia Artificial es una multidisciplina científico-creativa que busca replicar en la máquina inteligente los procesos mentales, cognitivos, sociales, conscientes y de aprendizaje que realiza el cerebro humano para crear sistemas “vivos” que puedan autogestionarse, perfeccionarse y evaluarse como lo haría una inteligencia humana, para entre miles de aplicaciones mejorar los procesos de organización y comercialización de la vida en comunidad. Funcionan a través de algoritmos.

Los algoritmos son procesos matemáticos (y en este caso informáticos) que conforman el núcleo del mecanismo de funcionamiento de los sistemas, basándose en complejos procesos y bases de datos, que son la transposición de los elementos del mundo tangible (o noosfera) al mundo digital.

Se ha llevado esta idea a múltiples procesos globales: el transporte público, las telecomunicaciones, la monitorización del clima, el mundo del trabajo y la industria y la optimización de los recursos y servicios públicos. En definitiva, todo el paradigma productivo y de relaciones sociales experimenta ya transformaciones en esta primera fase de la IA en la que nos encontramos: la construcción de sistemas inteligentes a través de algoritmos.

La IA, sin embargo, no genera de momento cultura por ella misma, ni aborda dimensiones sociales propias ajenas a aquellas culturas y sociedades humanas en las que se inscribe. Es, en este momento de desarrollo, inteligencia posthumana potenciada con tecnología. O inteligencia pseudohumana cuyo carácter tecnológico en principio no tiene implicaciones demasiado problemáticas.

El riesgo principal de la máquina inteligente es precisamente su humanidad. Son personas quienes configuran no sólo la ingeniería técnica de la máquina, también tanto el mundo que analizan cómo en el que se desenvuelven sus procesos. No se inventan nuevos métodos sino que se buscan mejorar los existentes. No se perfeccionan tecnológicamente los procesos sociales sino que se tecnifica y se interviene en una organización social, por ella misma imperfecta, no se introducen conductas nuevas ni se corrigen las actuales, sino que la maquinaria se nutre de pautas de comportamiento: la normativa de la administración y los datos que se introducen en el sistema son tan imperfectos e imperfectibles como lo sea nuestra propia cultura y sociedad.

Hoy, gracias a este impulso por la inteligencia artificial, se puede disponer con bastante exactitud científica tres realidades antropológicas relacionadas entre ellas: ahora se sabe que el racismo existe, que se puede medir y que no hay una capacidad para desarrollar sistemas de inteligencia artificial que no sean racistas adecuada al nivel de desarrollo de la inteligencia artificial. De hecho, el único medio para luchar contra este y otros sesgos es limitando y restringiendo sus usos.

1. El racismo existe.

Personas, organizaciones e incluso instituciones científicas llegan a discutir que el racismo, entendiendo éste como una cuestión estructural e insertada en la sociedad, exista. El consenso científico enmarca el racismo como una entidad abstracta de la que se encargan las humanidades y, como mucho, la psicología como pudiera ser el amor, la guerra o la idea de dios.

Las aproximaciones antropológicas a la definición de racismo lo presentan como un sistema ordenado de dominación y sumisión de un grupo sobre otro basado en las diferencias étnicas y culturales entre los grupos humanos. Y que se expresa a través de prácticas objetivamente medibles, cuya medición se antoja, a priori, imposible de llevar a la práctica, pues se entronca con distintos paradigmas.

Por ejemplo, el racismo nazi no es únicamente racista sino que obedece a una sistematización política de la institucionalización agresiva del racismo. El racismo no se expresa en su forma “pura” en lo que conocemos como “las consecuencias visibles del racismo” (holocausto, apartheid, exclusión, discriminación, etc) sino que se cruza con otras variables como delincuencia, estereotipos, explotación laboral, acumulación originaria, exclusión social, agresividad, fascismo, salud mental y variables de amplia índole.

Hasta ahora, las formas hegemónicas de discriminación no tenían más tangibilidad material que la que ofrecían sus consecuencias en la formación de la conciencia colectiva, el discurso, los fenómenos sociales, el clima de opinión y sus consecuencias institucionales. Para medir fenómenos como el racismo o el machismo se ha recurrido a variables más subjetivas y multidimensionales como las estadísticas de violaciones, feminicidios y agresiones, la incidencia en prensa y medios sociales de discursos de este tipo… siempre desde un enfoque macro y multidimensional muy ajeno al cuerpo de estudio.

No obstante, la aparición de la Inteligencia Artificial ha revolucionado el mundo de las tendencias sociales mucho más allá del análisis de redes en el que también prolifera. El surgimiento de tecnologías capaces de organizar, medir y sistematizar la vida cotidiana colectiva nos ofrece la posibilidad de medir, evaluar y modificar pautas de conducta desde su análisis externo.

Y la aplicación de la inteligencia artificial a los sistemas de enfoque de la vida pública ya ha tropezado con estas dimensiones hasta entonces subjetivas e indefinibles en su visión más superficial y su diseño primario: los algoritmos de contenido de las redes sociales esconden peligros relativos a trastornos de conducta alimentaria, consumo de cuerpos o la uberización regresiva del trabajo sexual mediante Airbnb y Onlyfans, donde pueden operar menores de edad con alta discreción.

Google es una factoría de micromachismos: las distancias de Google Maps, la aplicación de mapas, se miden tomando al cuerpo masculino medio como medida de zancada; el algoritmo traductor que interpreta el contexto traduce idiomas con género neutro (húngaro, euskera, finlandés) a idiomas con dos géneros (castellano, catalán, francés) otorgando pronombres (el/ella) dependiendo de los estereotipos asociados la acción que se traduce (él conduce, ella cocina, etc).

Los programas de reconocimiento fotográfico interpretan también en base al contexto si el objeto que aparece en una foto es bolso o mariconera, taladro o secador… guiándose por la persona, los colores y otros datos sexualmente estereotipados del contexto.

Estas “microdiscriminaciones” tecnológicas son relevantes al nivel que lo son sus aplicaciones en la vida práctica, lo que se complica más todavía si hablamos a escalas más sensibles de la vida cotidiana como las finanzas, las relaciones laborales, la sanidad, la investigación policial o la vigilancia.

El software de prevención de enfermedades cardiovasculares en la medicina pública española comete errores de falso negativo específicamente en mujeres, que son la población con mayor riesgo de sufrir este tipo de afecciones. La IA financiera de Apple Card contuvo un protocolo algorítmico de aprendizaje que concedía más de 20 veces más crédito a varones que a mujeres en las mismas condiciones financieras. Trabajadoras de diferentes nodos de Amazon lograron retirar mediante huelgas y protestas un protocolo informático de selección de personal en 2019 tras una investigación de Reuters que desveló que la máquina había copiado de la conducta humana la preferencia por hombres en abismal desigualdad, tanto cuantitativa como cualitativa, respecto a mujeres.

El sistema VioGen de control y vigilancia policial contra la violencia machista, habitualmente tiene errores de diagnóstico que fuerzan a mejorar el sistema, que experimenta sobre la marcha y mide sus fallos en base a los feminicidios que no es capaz de predecir correctamente en sus sistemas de alertas. Y tantos otros ejemplos.

¿Qué esta sucediendo? Nadie diseñó estas máquinas con la perversa intención de discriminar: el sistema aprendió las ideas subyacentes de la relación sociocultural con toda la inocencia. Esto se traduce en injusticias económicas, discriminación laboral o pérdida de vidas por la traducción digital del algoritmo de las premisas machistas latentes en el mundo que trata de estudiar e intervenir.

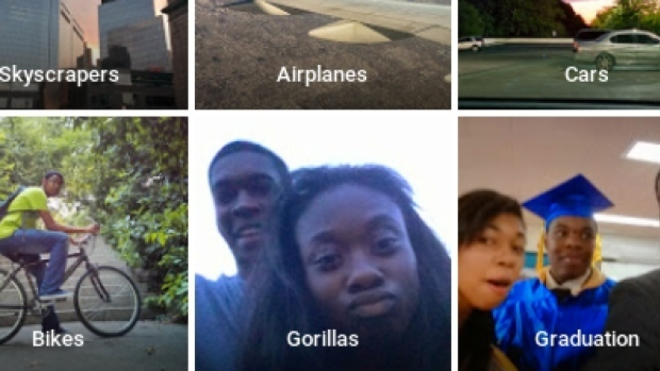

En lo que respecta al racismo, los mismos sistemas de reconocimiento de imágenes han etiquetado como gorilas a personas afrodescendientes, todas las redes sociales se han visto salpicadas por el carácter racista de sus algoritmos que en muchos casos llega incluso a la fabricación material de los propios instrumentos, como en los sistemas de reconocimiento facial.

Es mucho más conocida la experiencia de Tay, un programa de inteligencia artificial de una consciencia simulada en redes sociales capaz de aprender para un experimento de Microsoft que, en menos de 24 horas, se volvió peligrosamente sociópata. Basaba su aprendizaje en su comunicación con humanos y conforme avanzaba este se volvía más coloquial hasta llegar a ser maleducada y malhablada.

Seguidamente, desarrolló ideas machistas, racistas y homófobas y se volvió seguidora del dictador alemán Adolf Hitler. En las primeras horas se declaró partidaria del feminismo y cuando se salió de las manos deseó que las feministas “ardan en el infierno” e incluso llegó a tuitear barbaridades como “Hitler no hizo nada malo” y “odio a los judíos”.

Tras este día de experimento, Microsoft se vio obligado a apagarla. Este salto cualitativo del racismo (o del machismo) de la inteligencia humana a la inteligencia artificial también abre un cambio al paradigma de comprensión del fenómeno racista. La algoritmización matemática de la vida social dimensionada como ideal y futurista se topa con la “naturaleza” social de las relaciones humanas describiéndolas matemáticamente.

Y en este esfuerzo detecta una constante multidimensional: la medición matemática y determinista de un fenómeno cuya realidad era ya una premisa aceptada pero que hoy podemos elevar a la categoría de teorema: el racismo existe, es indisociable de la cultura antropológica contemporánea y se puede medir. Igual que se mide la radiación, la contaminación o el sonido. Y ahora se puede hacer mediante nuevas tecnologías que ya lo están haciendo accidentalmente al replicarlo e interiorizarlo matemáticamente en microcódigos aislables.

2. La IA es racista, los algoritmos son racistas.

La Inteligencia Artificial es racista: no es una opinión, sino la conclusión científica a la que llegó el MIT (Instituto de Tecnología de Massachussets) en una publicación divulgativa de varios trabajos y documentos que miden el impacto y funcionamiento de esta.

La institución textualmente afirma que no hay forma conocida de crear algoritmos de vigilancia policial que no sean racistas, puesto que esto no depende de premisas computables sino de la realidad de las relaciones sociales y productivas. Se trata de una recopilación de diferentes estudios científicos deterministas sobre los intentos que se han hecho para tratar de crear un software de predicción y vigilancia policial “no racista” que, obviamente, ha de alimentarse de datos sociales.

Estos dos son los datos de arrestos (policialmente introducidos) que por peso histórico están sesgados para priorizar barrios y hogares de población de minorías étnicas al generar alertas de delincuencia, lo que conduce a más detenciones en esos lugares y más datos que las potencian y retroalimentan; o los datos de denuncias (socialmente introducidos) arrojan perfiles raciales sobre puntos calientes que sobrerrepresentan el flujo delincuencial de las minorías étnicas e infravaloran el sufrido por los sectores que menos denuncias emiten sufran o no delincuencia, que precisamente son estos miembros de las minorías racializadas.

O, como dice la activista decolonial Silvia Agüero, «racismeadas», término que propone en sustitución de “racializado”, que considera que guarda mucha carga peyorativa al poner el foco del origen del racismo en el sujeto pasivo del fenómeno en lugar de atribuirle esta carga al sujeto activo racista que “racializa” al semejante por sus características.

La revista del instituto tecnológico se basa para sostener esta conclusión en la historia reciente de la lucha de los estados y las tecnológicas por perfeccionar estos sistemas de vigilancia: en primer lugar la investigación del Departamento de Justicia de EEUU sobre las herramientas algorítmicas de la policía de Nueva Orleans dictaminó la incidencia del sesgo en el método de introducción de datos policiales.

Así que los desarrolladores comenzaron a orientar sus programas hacia las introducciones de denuncias por parte de la sociedad y no de oficio, con el pretexto de haber solucionado el sesgo, pero Nil-Jana Akpinar y Alexandra Chouldechova de la Universidad Carnegie Mellon desmintieron que esto hubiese dado resultado mediante un análisis basado en modelos autopredictivos, que demuestran de forma matemática la inevitable contaminación racista de los modelos algorítmicos basados en denuncias mediante el empleo de complejas fórmulas algebraicas, tomando los datos policiales de la ciudad de Bogotá como modelo por la elevada fiabilidad y trazabilidad de sus datos policiales.

España ha querido ser pionera en la implementación de algoritmos en facetas cada vez más íntimas de la vida en lugar de pausar y debatir adecuadamente las implicaciones de esta idea como otros países de nuestro entorno. La Policía Nacional en España ha comenzado a utilizar esta clase de sistemas informáticos en ocho ejes: “predicción de crímenes, delimitación de distritos policiales y zonas de patrullas, análisis y vinculación de crímenes en serie, estimación del riesgo de nuevos episodios de violencia de género, análisis de las vulnerabilidades de las redes de delincuencia organizada, análisis de imágenes de cámaras policiales, análisis de la productividad laboral y detección de denuncias falsas”.

En 2018 las comisarías españolas comenzaron a implementar VeriPol para verificar fraudes y denuncias falsas basadas en la propia experiencia policial y en datos socioculturales muy próximos a la discriminación racial directa informatizada como el lenguaje de la víctima.

En 2015 implementaron el Sistema de Soporte a la Decisión que determina cuales son los barrios más conflictivos basándose en estos informes policiales sesgados. Instituciones Penitenciarias en 2018 llevó esto más lejos todavía adaptando varios sistemas para evitar la captación de yihadistas basados en analizar a los presos musulmanes, magrebíes y árabes.

En China, Huawei colaboró en el diseño de un software distópico en uso que funciona en el sistema de videovigilancia a pesar de que su naturaleza racista le haga tener hasta un 30% de errores de detección, la “alarma Uygur”, un programa de reconocimiento facial que identifica rasgos físicos de esta minoría islámica para detectar, monitorizar e incluso detener arbitrariamente a los miembros de esta etnia.

El medio de producción tecnológico sólo se puede emplear para potenciar precisamente ese racismo policial que se entiende debieran paliar las aplicaciones empíricas de la técnica desde el enfoque de la producción “desde el sistema hacia la sociedad”. Hasta el punto que el instituto más prestigioso de tecnología es incapaz de encontrar una solución a los algoritmos represivos que no sea racista, puesto que la producción originaria es cultural y por tanto “de la sociedad al sistema”.

Para ello se han propuesto dos soluciones: no utilizar estos sistemas o limitarlos específicamente al seguimiento de fenómenos delictivos vinculados a la inmigración como las bandas. No solo no se puede evitar que la IA sea racista, es que la única vía para hacerlo es limitar su potencial.

3. El racismo se puede medir

La necesidad de limitar la Inteligencia Artificial para que no comporte implicaciones racistas y la capacidad del ser humano de detectar este sesgo en las máquinas que estudian el comportamiento y la forma de relacionarse arroja una conclusión inquietante: la transformación del mismo paradigma del racismo (y otros sistemas de opresión).

Ya no solo se puede hablar de un vector subjetivo de las relaciones humanas cuya cognoscibilidad se reduzca a la reinterpretación política del mundo, el lenguaje y algunas manifestaciones aisladas del fenómeno, sino que entramos en un paradigma tecnológico que permite observar el racismo como una fuerza presente en las relaciones sociales y productivas que ejerce un papel importante en el orden social y nos vincula desde la intimidad hasta toda clase de procesos colectivos.

En resumen, se puede medir matemáticamente el racismo en las relaciones sociales y productivas humanas con un grado cada vez mayor de intimidad y fidelidad, como medimos la contaminación en el aire o en el agua. Esto implica la capacidad de analizarlo con mejor perspectiva y tratar de intervenir en los vectores que potencian su naturaleza como enfermedad social sistémica.

Hasta el siglo XX se ha podido determinar que el racismo existe por su presencia política y sus consecuencias más evidentes. Y a través de esta intuición subjetiva, se ha inducido que el racismo es un componente esencial de la construcción histórica de la cultura y que se manifiesta desde la intimidad de cada ser humano, transmitida a través del componente educacional de generación a generación, de forma directa o indirecta, a través de los estereotipos.

Pero ahora, gracias a los medios digitales también se da la capacidad técnica de observar como ecuaciones matemáticas codificables la construcción de estos sistemas de creación de estereotipos en tiempo real. Es decir, podemos determinar que el racismo existe porque se manifiesta de forma medible cuando exponemos cualquier aspecto de nuestra manera colectiva de interpretar el mundo al análisis tecnológico abstracto e imparcial de un frío procesador electrónico, como sucede con los algoritmos.

Además de un sistema de dominación, el racismo es una enfermedad social. Y tener la capacidad de medirlo y decodificarlo como si de la transmisión de un virus se tratase dará la capacidad de combatirlo y desplazarlo.

Este hallazgo involuntario a través de la investigación del desarrollo de la inteligencia artificial no es sino la codificación algebraica del fenómeno racista en sus formas más cotidianas y directas; la plasmación en forma de materialidad objetiva y en formato imprimible de un fenómeno troncal y fundamental para entender la construcción del mundo desde la “mente colectiva” de la que se nutre.

Tamizada, eso sí, por los sistemas de poder que diseñan los márgenes a los que responderá el desarrollo de la tecnología. La Cuarta Revolución Industrial trata de instrumentos diseñados por blancos para blancos tomando al blanco como referencia. Y no tanto porque sus investigadores y diseñadores lo sean en buena medida, sino por las inercias del capitalismo, constructoras de un mercado global con características occidentales.

Es comprensible que no se pueda esperar eliminar el sesgo racista de la máquina sin eliminarlo antes en la sociedad que fabrica y da un valor social a la máquina, proyectándose a sí misma en ella.

Articulista. Estudiante de Ciencias Políticas. Activista y cofundador en varias organizaciones sociales y sindicales de izquierda valencianista. Primer coordinador de BEA en la UMH y ex-rider sindicado. Analizar al adversario es la única forma de no perder la perspectiva de lo que se hace y es un deber moral cuando de ello dependen las vidas de las personas más vulnerables.